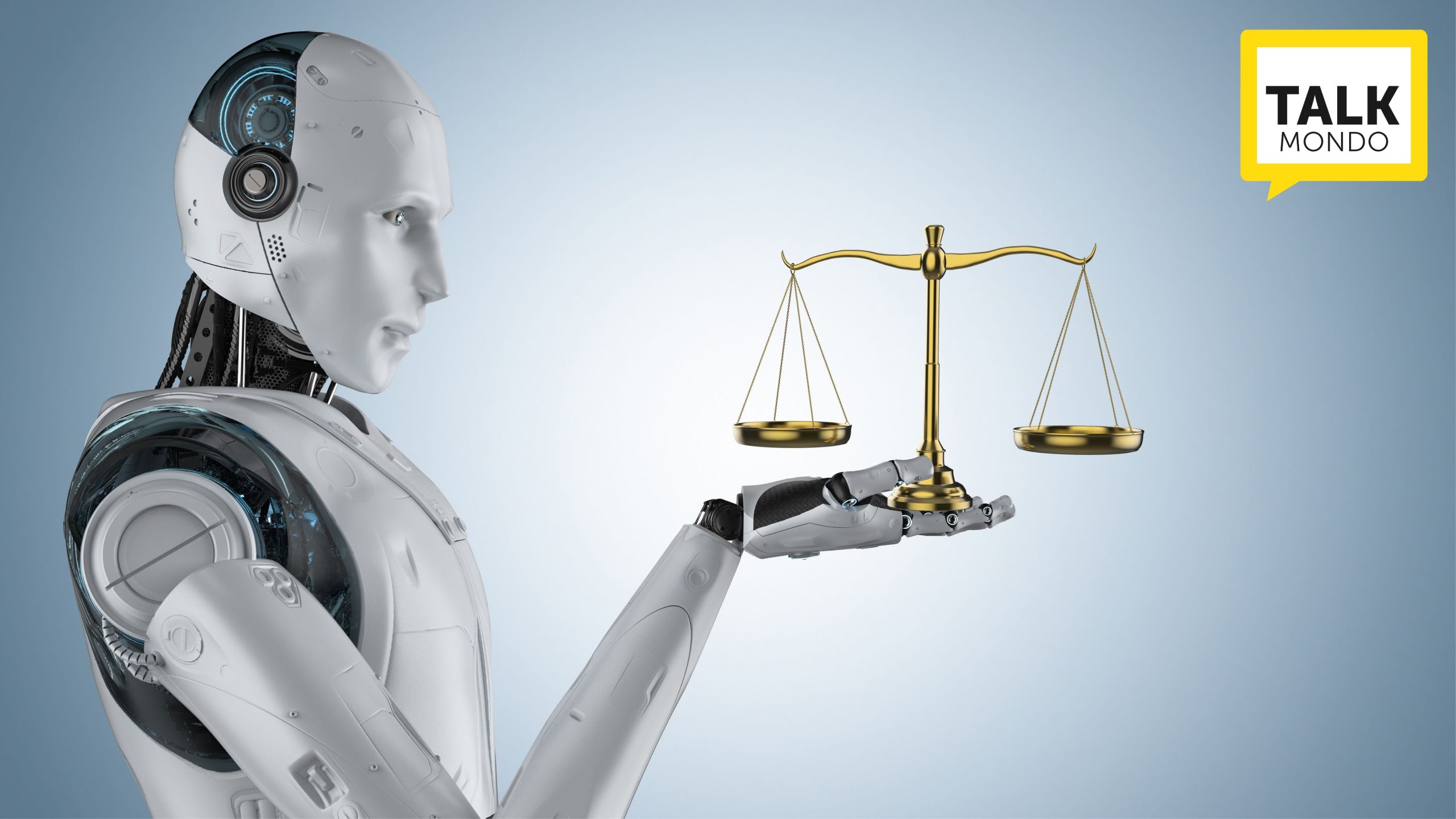

Si immagini questa scena: un’aula di Tribunale, un processo penale, in cui è presente un solo uomo in carne ed ossa, l’imputato. Perché giudice, pubblico ministero e avvocato sono robot, con una toga sulle spalle forse, per dar loro una sembianza umana, ma pur sempre dei robot.

L’imputato legge su un monitor i capi di imputazione a suo carico, così come su uno schermo scorrono le domande e le risposte dell’esame e del contro esame dei testimoni, accanto a una cifra percentuale che, mutando, indica il grado di probabilità che venga assolto o condannato e la quantificazione della pena che gli può essere inflitta.

Poi tocca a lui esporre le sue ragioni: legge sul monitor le domande, risponde, cerca di dare la sua versione dei fatti, spiega il perché e il per come del suo agire, e nel farlo si emoziona, come è giusto che sia.

Volge infine lo sguardo al giudice per capire se le sue parole hanno fatto breccia, ma la risposta gliela dà il monitor, in cui la percentuale di assoluzione/condanna si trasforma in certezza e, nel secondo caso, viene anche quantificata la pena.

Il processo è finito, allo Stato non è costato nulla (se non la corrente elettrica per alimentare i robot) ed è stato velocissimo.

Scenario da Grande Fratello orwelliano o da Città del Sole di Campanella? Ma, soprattutto, ne siamo così lontani?

IL ROBOT-PUBBLICO MINISTERO CINESE È GIÀ AL LAVORO

Lo scorso 26 dicembre il South China Morning Post, una testata di Hong Kong, ha riferito che la Procura del Popolo di Shanghai Pudong ha elaborato un algoritmo di Intelligenza Artificiale in grado di esaminare fascicoli ed elaborare capi di imputazione.

Non si tratta di un robot con le fattezze umane ma, come detto, di un algoritmo caricabile su qualunque computer in commercio che, attraverso l’esame dei verbali di polizia e degli altri documenti presenti nel fascicolo, opera una selezione tra ciò che è rilevante e ciò che non lo è, esamina il materiale non scartato, ed effettua una valutazione dei punti chiave, quali gli elementi indiziari, per giungere ad una conclusione e formulare un vero e proprio capo di imputazione.

Secondo il professor Shi Yong, direttore dell’Accademia cinese delle Scienze dei “Big Data” e capo del team di sviluppatori, l’algoritmo prenderebbe in considerazione più di 1.000 potenziali elementi tra loro concordanti o discordanti (testimonianze, verbali, rilievi, transazioni bancarie etc.), in ciò basandosi sui dati di oltre 17.000 casi giudiziari realmente avvenuti nel periodo 2015-2020, e arriverebbe a formulare imputazioni “corrette” nel 97% dei casi.

Pur limitandosi per il momento a sole 8 diverse fattispecie di reato (frode con carta di credito, scommesse clandestine, guida spericolata, violenza intenzionale, intralcio all’attività pubblica, furto e frode generica), il software promette grandi sviluppi per l’immediato futuro, soprattutto in considerazione della mole di lavoro che può far risparmiare ai pubblici ministeri in carne ed ossa i quali, viene precisato, restano comunque gli ultimi responsabili delle decisioni, potendosi essi ben discostare da quelle assunte dall’algoritmo accusatore.

TANTO RUMORE PER NULLA?

La notizia ha impressionato e ha fatto di corsa il giro del mondo, accompagnata sovente da immagini di un androide con il martelletto da giudice in mano. Ma è davvero così sconvolgente?

Se si guarda alla realtà quotidiana, bisogna riconoscere che l’Intelligenza Artificiale è ormai presente ovunque: dai navigatori che calcolano il percorso meno trafficato per giungere alla destinazione prescelta, al nostro smartphone che prevede quale sarà la prossima parola che inseriremo nel testo che stiamo scrivendo, all’algoritmo che suggerisce l’operazione di borsa potenzialmente più vantaggiosa, al software dell’Agenzia delle Entrate che incrocia gli elementi indicatori del tenore di vita con i redditi del contribuente per valutarne la compatibilità.

E che dire dei social network che selezionano i post per noi potenzialmente più interessanti dopo aver esaminato e tracciato la nostra navigazione, o del Braking Assistance System, montato sui veicoli di nuova produzione, che aziona da solo i freni della nostra macchina se le telecamere avvistano un oggetto fermo innanzi a noi, così come degli altri innumerevoli servizi di assistenza alla guida che usiamo ormai senza nemmeno accorgerci e che ci porteranno a breve a salire su autoveicoli a guida completamente autonoma?

Perché allora la notizia dell’introduzione dell’Intelligenza Artificiale nel sistema della Giustizia ha fatto sobbalzare molti, compreso chi scrive? Perché la macchina, sotto certi profili, spaventa. A maggior ragione se invade un settore umano, troppo umano, qual è appunto quello della Giustizia, in particolare quella penale.

POTENZIALI PERICOLI

Una prima fonte di inquietudine è legata al possibile abuso che l’uomo può fare, a proprio vantaggio, della macchina.

I media occidentali che hanno ripreso la notizia del “procuratore robot” cinese hanno subito evidenziato che tra le fattispecie criminose di cui questo si può occupare rientra anche un reato di natura potenzialmente “politica”, quello rubricato come “Intralcio all’attività pubblica”.

L’aumento di efficienza nel perseguire questo reato, derivante dall’implementazione dell’algoritmo accusatore, potrebbe portare non solo a una maggiore capacità del regime governativo di reprimere condotte di dissenso politico, ma altresì a una sorta di deresponsabilizzazione dell’apparato giudiziario che, soprattutto ove il processo di automazione si estendesse anche alla decisione del giudice, potrebbe invocare l’infallibilità della macchina (per ora stimata non si sa bene come dagli scienziati al 97%) per sostenere la correttezza di qualsiasi provvedimento giudiziario.

In realtà, non occorre vivere in Cina per inquietarsi di ciò, perché reati di matrice “politica” o “ideologica” sono presenti negli ordinamenti di ogni paese del mondo, compresi quelli a regime cosiddetto “democratico”, compreso il nostro.

Sotto altro profilo, preoccupa la fallibilità della macchina, vale a dire la potenziale “stupidità” dell’Intelligenza Artificiale, che in alcuni casi può avere conseguenze tragiche.

Un esempio: a fine 2018 e inizio 2019 un nuovo modello di aereo della Boeing, il 737 Max 8, fu oggetto di due strani incidenti: due velivoli precipitarono, senza ragione, subito dopo il decollo. Dall’esame delle scatole nere si appurò che entrambi gli aerei, per un difetto del software di navigazione che credeva erroneamente che l’aereo avesse un angolo di inclinazione troppo verticale, effettuavano in automatico il “trim down”, cioè ne abbassavano il muso, provocandone la successiva caduta, senza che i piloti potessero manualmente intervenire per correggere l’errore dell’Intelligenza Artificiale.

A seguito dei due incidenti, avvenuti in Indonesia e in Etiopia, in cui sono perite 346 persone, è stata aperta un’inchiesta a carico della Boeing, che ha appurato che il software dell’aereo era stato appaltato a lavoratori indiani, privi della necessaria esperienza in materia e sottopagati.

La vicenda in questione chiarisce abbastanza bene come l’Intelligenza Artificiale, a conti fatti, non sempre sia così intelligente, poiché il suo livello dipende in gran parte dalla qualità dei suoi creatori (responsabili del sistema di ragionamento artificiale) e dalla correttezza dei dati immessi, che verranno utilizzati come del funzionamento dell’IA stessa.

Di più: questa vicenda, ma si potrebbero fare mille e mille altri esempi, chiarisce anche che, quando l’Intelligenza Artificiale sbaglia, lo fa in modo clamoroso, per il semplice fatto che si blocca e difficilmente è in grado di aggirare il problema come farebbe, o almeno tenterebbe di fare, un cervello umano.

Il che non stupisce giacché, in fondo, i computer si limitano a eseguire calcoli nel vero senso della parola, mentre il funzionamento del nostro organo pensante è diverso e molto più complesso. Ma anche limitandoci alla potenza, secondo due ricercatori delle università di Berkeley e Carnegie Mellon, che hanno effettuato un raffronto tra la velocità con cui un computer sposta le informazioni all’interno del suo sistema e la frequenza con cui i nostri neuroni emettono i segnali elettrici, il cervello è ancora circa 30 volte più veloce dei più potenti supercomputer del mondo.

POTENZIALI RIMEDI

Questi ed altri rischi sono ben presenti agli occhi della comunità scientifica, che deve averne messo a parte quella politica, visto che l’UE nell’aprile del 2019 (seguita a ruota dalla Cina) ha elaborato e adottato delle Linee Guida Etiche sull’intelligenza artificiale, elaborate da un Gruppo di Esperti incaricati dalla Commissione Europea.

A queste ha fatto seguito l’approvazione da parte del Parlamento Europeo, il 20 gennaio 2021, di una risoluzione che, per quanto riguarda il settore della Giustizia, prevede che “l’uso delle tecnologie dell’IA può contribuire ad accelerare i procedimenti e a prendere decisioni più razionali, ma le decisioni finali dei tribunali devono essere prese da esseri umani, rigorosamente verificate da una persona e sottoposte ad un giusto processo”.

Come accennato, anche la Cina ha adottato propri principi etici per un uso corretto dell’Intelligenza Artificiale, pubblicando il 25 maggio 2019 un documento denominato “Consenso dell’intelligenza artificiale di Pechino“, contenente per la verità un elenco di petizioni di principio abbastanza generiche, mentre dal lato U.S.A. solo il colosso privato Google ha individuato e reso note norme etiche interne in materia, se possibile ancora più generiche di quelle cinesi.

CONDANNATI (O ASSOLTI) DAI ROBOT?

Quali sono dunque in concreto, se non per oggi per un domani non troppo lontano, le probabilità che si avveri lo scenario descritto all’inizio di questo articolo, con un imputato umano circondato da soli robot? E quali sarebbero i rischi di una simile eventualità?

A modesto parere di chi scrive, in un futuro abbastanza prossimo tutto ciò potrebbe divenire realtà. Magari senza la sceneggiata degli androidi in aula con la toga sulle spalle, magari semplicemente per via telematica, stando davanti a un monitor.

Il processo telematico, sia quello civile che quello penale, sebbene quest’ultimo in forma ben più limitata, sono ormai una realtà.

Se è pur vero che l’algoritmo di Shanghai al momento formula solo capi di imputazioni e non sentenze, è anche vero che il valutare se procedere o meno contro qualcuno per un reato e fissare l’accusa, descrivendo le condotte che si assumono integrare gli elementi di una fattispecie criminosa prevista e punita dalla legge, è un già processo decisionale, aggiungo di notevole rilevanza processuale.

Da qui ad affidare ad un algoritmo di Intelligenza Artificiale anche l’atto decisionale proprio del giudice il passo non è troppo complesso, anzi, a ben vedere si tratterebbe di un’operazione concettualmente analoga.

Del resto, l’invio di avvisi di accertamento e addirittura l’irrogazione di sanzioni attraverso sistemi automatizzati in materia amministrativa (ad es. multe per autovelox o per accesso in zona a traffico limitato) o tributaria (incrocio dei dati bancari/reddituali e delle relative dichiarazioni al fisco) è già da parecchi anni una realtà, e nulla vieta, almeno sul piano concettuale, che ciò possa essere esteso anche al settore della Giustizia penale, eventualmente accompagnando il tutto con sistemi di verifica umana preventivi o successivi.

Un primo caso di applicazione della Giustizia governata dall’Intelligenza Artificiale potrebbe essere costituito dal procedimento per decreto, dove già ora la condanna avviene senza né processo né alcuna forma di contraddittorio tra accusa e difesa, salvo prevederne la revocabilità e la riconduzione alle forme ordinarie di accertamento della responsabilità in un’aula di tribunale davanti a un giudice, un pubblico ministero, un difensore, dei testimoni etc., solo in caso di opposizione al decreto stesso.

Ma i quali sono i pericoli, nell’ipotesi di processo penale interamente affidato agli algoritmi? A mio giudizio tanti, troppi, anche in presenza dell’ipotesi in cui l’Intelligenza Artificiale resti sotto il potenziale controllo umano.

Ne balza in mente subito uno: qualche imputato, soprattutto se facoltoso, potrebbe ricorrere ad hacker professionisti per condizionare l’algoritmo della Pubblica Accusa o del Tribunale e ottenere archiviazioni o addirittura sentenze di proscioglimento. Così come, al contrario, si potrebbe alterare il funzionamento del giudice-software per incriminare e poi far condannare innocenti.

Si tratta di un rischio contenibile attraverso il controllo umano sul provvedimento emanato dalla macchina, tuttavia è un rischio grave.

Che dire poi dei possibili (e più che probabili) errori di inserimento dei dati e di programmazione del sistema di giudizio, i cui meccanismi operativi sarebbero di difficilissima verifica, soprattutto da parte dei non addetti ai lavori?

Ma al di là di tutto ciò, è proprio il fatto che la macchina giudichi l’uomo che non convince né potrà mai convincere.

Come può una fredda Intelligenza Artificiale valutare una testimonianza? Non solo per la coerenza interna ed esterna del contenuto delle dichiarazioni, ma anche per quel che concerne le pause, i cambiamenti nel tono della voce, i gesti e le mimiche facciali del testimone.

Come può valutare la gravità, la precisione e la concordanza degli indizi a carico dell’imputato (art. 192, comma 2 c.p.p.), e giungere a stabilire se l’accertamento della responsabilità sia avvenuto o meno “al di là di ogni ragionevole dubbio” (art. 533, comma 1 c.p.p.)?

E i criteri per stabilire la gravità del fatto e la capacità a delinquere elencati all’art. 133 del codice penale di cui il giudice deve tenere conto per stabilire la pena da applicare, li può valutare una macchina?

Qualora l’Intelligenza Artificiale raggiungesse un elevatissimo livello di capacità di elaborazione e venisse munita di un database contenente tutte le disposizioni di legge dell’ordinamento, accompagnate dai relativi precedenti giurisprudenziali, in teoria i quesiti di cui sopra potrebbero essere risolti anche da una macchina, in alcuni casi forse anche meglio di come vengono affrontati e decisi dagli attuali giudici in carne ossa. Eppure…

UMANI, TROPPO UMANI

… Eppure l’idea che un essere umano, il suo agire, venga giudicato non da un suo simile ma da un algoritmo inquieta non poco. Perché?

Perché, al di là e, soprattutto, al di sopra della Legge e del Diritto, vi è l’Aequitas, intesa come esigenza di adeguamento del diritto a sentimenti di Giustizia, concetto sfuggente agli stessi uomini – figurarsi alle macchine – ma la cui assenza non è tollerabile nelle aule di tribunale, soprattutto in quelle dove si celebrano i processi penali.

Ben può essere che in un non tanto remoto futuro saranno gli algoritmi a valutare, in pochi secondi e anche più correttamente degli esseri umani, quali siano le norme applicabili, il grado di attendibilità delle prove, la gravità della condotta e la personalità dell’imputato, e quindi a decidere della sua vita. Sarebbe il trionfo di ciò che gli antichi esprimevano con la formula dura lex, sed lex.

Ma accanto e in contrapposizione a questa, da Cicerone (De Officiis I, 10) in poi, esiste anche il brocardo summum ius, summa iniuria: la fredda applicazione della norma produce sovente la più grande ingiustizia. Arriverà mai una macchina a comprendere ciò?

E infine, dettaglio da non trascurare, la Giustizia è amministrata “In nome del Popolo” perché, chi è imputato, è accusato di aver commesso un reato, cioè di aver posto in essere una condotta talmente grave da aver leso in primis gli interessi della comunità in cui vive, comunità che lo giudica e, se del caso lo punisce, attraverso suoi rappresentanti, i giudici appunto.

Potrà mai il popolo delegare questa funzione a un algoritmo? Al lettore la risposta. Anzi, la sentenza!

di Ervin Rupnik – Avvocato del Foro di Roma